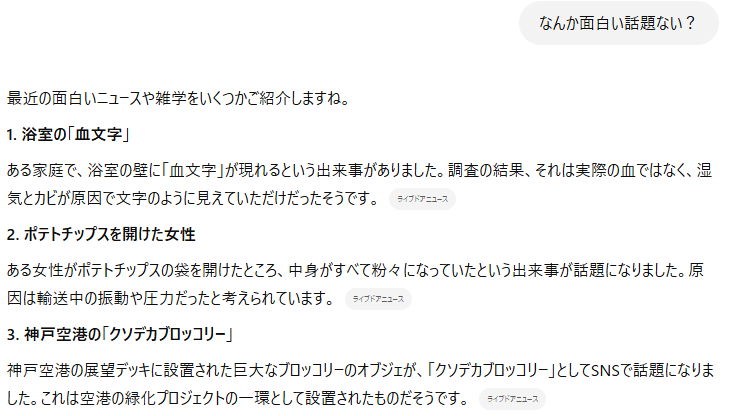

先日、このブログの記事を大変真面目に書き連ねるうち、ふと浮かんだ業務上重要な疑問をChatGPTにブラウザ機能をオンにして質問してみました。

ほーーーんクソデカブロッコリーか…

……

え、2番目マジでどうでもよすぎない?

ポテチの袋を開けたら中が粉々だったって…

サザエさんでも、もうちょい中身のある話をするぞ?

これがライブドアニュース…?え、マジかよ私もここの記者になれるんじゃないか?雇ってくれよお願いだから…

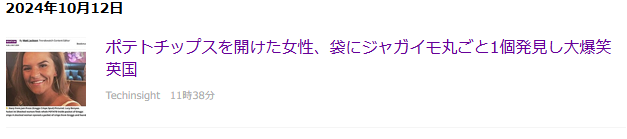

そう思って引用元のサイトを確認してみたところ…

ああこれかぁ。

……

…全然内容が違うじゃねぇか!!!

粉々どころか無加工そのままだったって話じゃん!

そりゃくだらない事件としてそこそこバズってこういうメディアで紹介もされるでしょうよ!

いろんな意味でくだらなくて笑ってしまいましたが、よくよく考えると結構これって問題というか…ChatGPT君がブラウザ検索をどう使ってるのか、疑問に感じ始めました。

だって検索したうえで、その内容を間違って教えてきてるってことですよね?これ。

AIがウソを教える事を「ハルシネーション」っていうんですけど、これって元々の学習データに誤りがあるせいで起きるって思ってたんですよ。

でも今回、ポテチの袋の中にジャガイモが丸々あったっていうだけの情報を、ChatGPT君は理解できずに勝手に自己解釈して、ポテチが粉々になったっていう情報に置き換えたってことになりますよね。

これは「AIの間違い」ではなく、明確な「AIのウソ」なんじゃないでしょうか。

元となった記事をしっかり読んでみても、どこにも「ポテチが粉々になった」という記載は見当たりません。

つまり完全に、ChatGPT君は自分の常識にあてはめて事実を捻じ曲げたってことになります。

そのことをやんわりと指摘してみましょうか…

間違いは誰にでもあるからね。まあ君はAIなんだけど。

もう一度調べて、その内容を教えてね。

いや聞いてない聞いてない!

ポテチの袋の開け方なんて全く聞いてないよ!!

え、マジかこいつ一応ChatGPT4oだよ?2024年12月(執筆当時)の時点で最新版だよ?

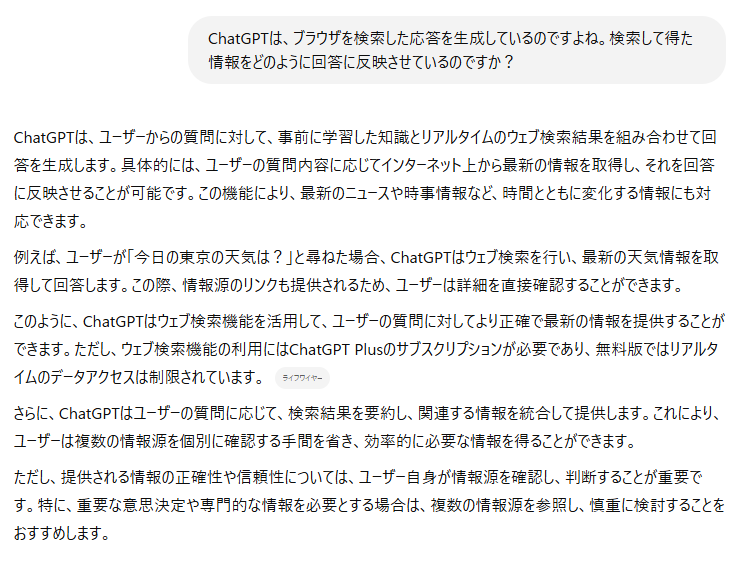

あまりにもアレだったので、どういう検索してんだこいつって聞いてみたところ、このような回答でした。

なんかごちゃごちゃ言ってますけど、フツーに検索して出てくる情報をしゃべってますよーってことらしいですね。

まあ最後の部分の、「ユーザー自身が情報源を確認し~」ってとこが今回重要だったって話なんだけど…

まさかここまでガッツリ嘘を言ってくるとは思わず、さすがにビックリしてしまいました。ここまでくだらない内容の記事だったからまだしも、もっと大事な内容でも同じように嘘ついてくるんだなこいつ…

しかしこういうウソの精査も、いちいちやっていたら時間がかかって仕方ありません。

ブラウザ検索機能はとても便利ですが、今のところ使い道は少し考えた方がいいのかも…?

ちょっとそう思ってしまう出来事でした。

ちなみにですが私は普段、ブラウザ検索機能はOFFにしています。

なんか検索したうえで話してほしいなーってとき以外は切っておいた方が、会話がスムーズになりますからね。

画像生成を頼むときなんかも、ブラウザ検索をONにしてると生成してくれなくなります。参考までに。